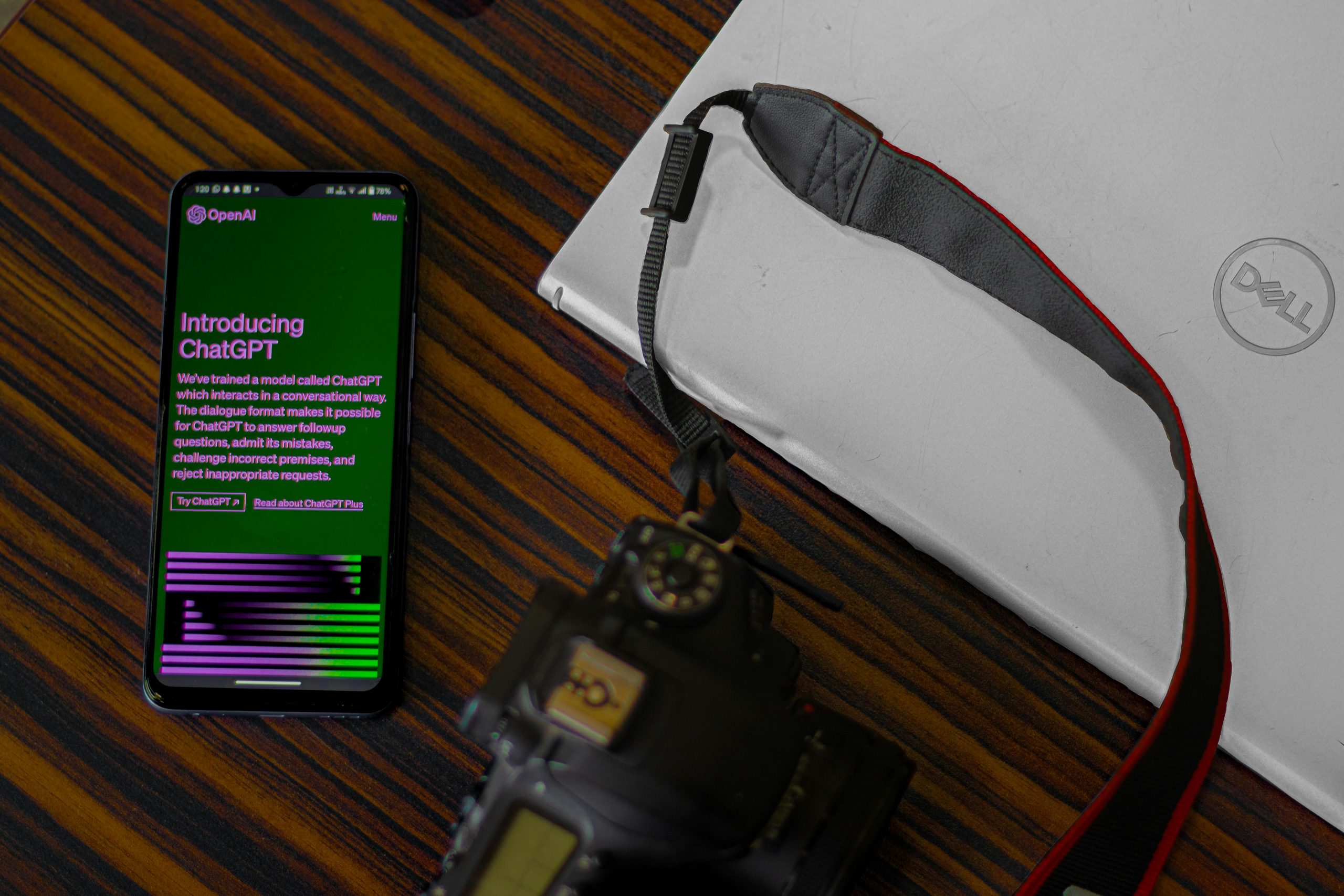

A OpenAI, responsável pelo desenvolvimento do ChatGPT, anunciou nesta segunda-feira (13), o lançamento do GPT-4o, a mais recente versão do seu modelo de inteligência artificial. Este novo modelo é o primeiro da OpenAI projetado para integrar e entender textos, imagens e áudios em tempo real, uma capacidade que marca um avanço em relação ao seu anterior, lançado em março de 2023.

++ Cientistas desvendam método para limpar nocivos “químicos eternos” presentes na água

O GPT-4o promete uma experiência de interação mais dinâmica e natural, permitindo que os usuários conversem e mostrem informações ao robô conversador, recebendo respostas quase instantâneas. Essa evolução visa aproximar a comunicação com a IA à de uma conversa humana, onde se pode falar e mostrar coisas para o robô, em vez de apenas digitar.

A novidade gerou comparações nas redes sociais com a assistente virtual do filme “Ela” (“Her”, no título original), onde o protagonista desenvolve uma relação emocional com um sistema operacional. Essa comparação chegou até Sam Altman, CEO da OpenAI, que mencionou o filme em seu perfil no X (antigo Twitter), destacando a relevância e o impacto cultural do novo modelo.

++ Ministério da Saúde enviará 105 mil doses adicionais de vacinas ao RS

Para demonstrar as capacidades do GPT-4o, a OpenAI divulgou vídeos de exemplos práticos. Em um deles, uma pessoa pede ao ChatGPT para avaliar sua roupa para uma entrevista de emprego, enquanto em outro, o modelo é usado para compor uma música. Essas demonstrações ilustram a versatilidade e a profundidade de compreensão do novo modelo, que promete transformar a forma como as pessoas interagem com inteligências artificiais.

Não deixe de curtir nossa página no Facebook , no Twitter e também no Instagram para mais notícias do 111Next.